我想弄清楚 Clever AI Humanizer 是否真的值得使用,但我在网上找到的大多听起来都像是在做营销。我非常希望看到真实、不加滤镜的用户评价——你喜欢什么、遇到过哪些问题,在检测、价格或质量方面有没有坑,以及你是否会把它推荐给严肃的内容写作或自由职业写作使用。

Clever AI Humanizer:我的真实使用体验

非赞助、非合作,只是分享一下我尝试“折腾”它之后发生了什么。

我已经和各种 AI 人类化工具打了很久交道,一半是出于好奇,一半是因为 AI 检测器现在到处都是,跟 2004 年的浏览器弹窗一样泛滥。工具此起彼伏、名字天天换、网站说没就没,但核心问题始终只有一个:

它现在到底还能不能用,而不是只是在吃上个月的营销红利?

这次我主要测试的是 Clever AI Humanizer,入口在:

https://aihumanizer.net/

这是正版网站。目前已经有一些山寨站在外面乱跑了。

关于假“Clever”网站的一个小提醒

有几个人私信我要“正版” Clever AI Humanizer 的链接,因为他们点了 Google 广告进去,结果是一些名字很像的“仿品”。

套路通常是:

- 在名字里硬塞一个“humanizer”。

- 买 “clever ai humanizer” 的 Google 广告。

- 然后把你引流到:

- 各种付费墙

- 自动续费订阅

- 标着“免费试用”但实际上不免费的东西

就我目前看到的情况:

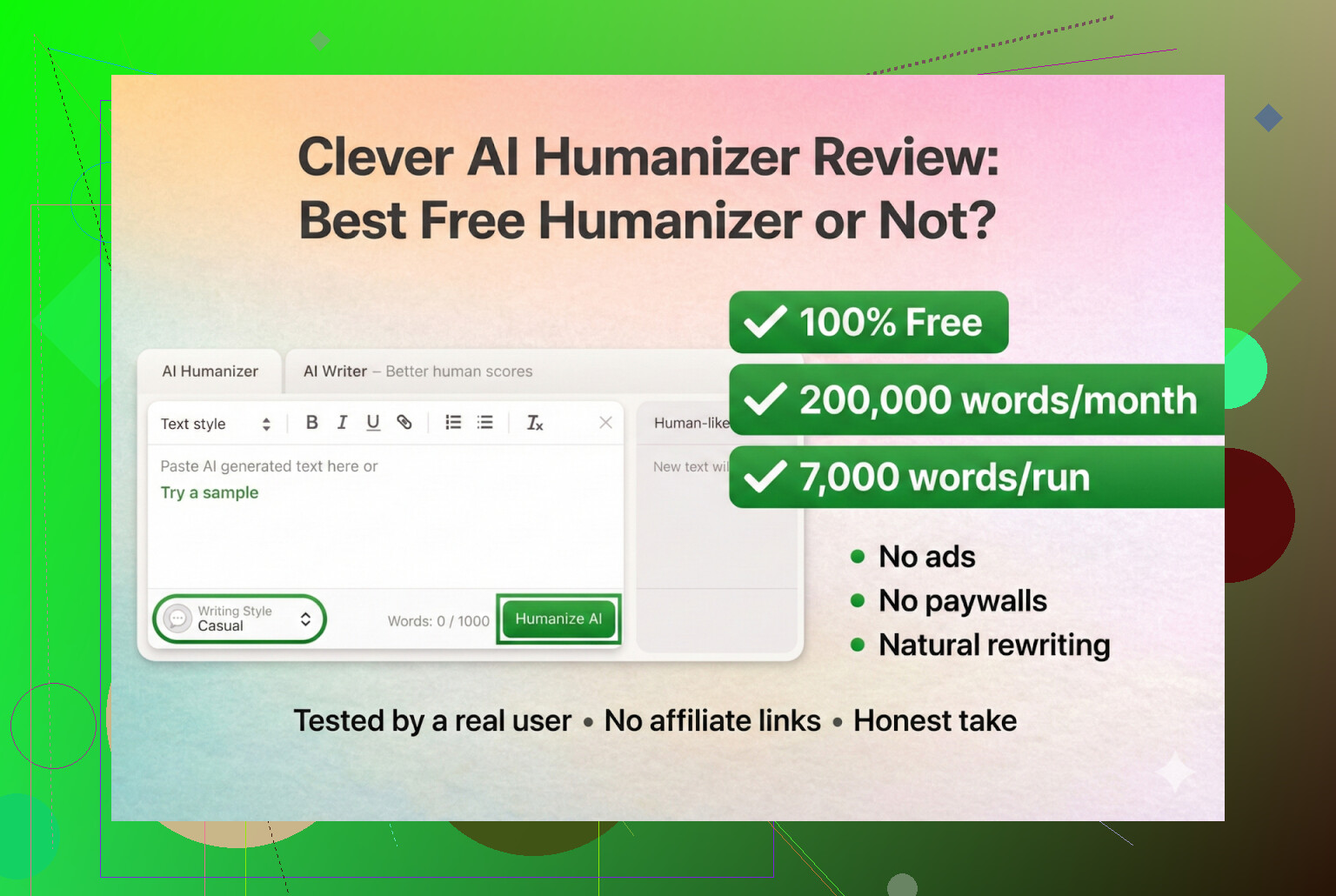

Clever AI Humanizer 没有高级套餐、没有加价销售、没有付费墙。

如果一个网站要你为某种“Clever”套餐付钱,那它就不是这个:Clever AI Humanizer — 最佳100%免费人性化工具

我是怎么测试的

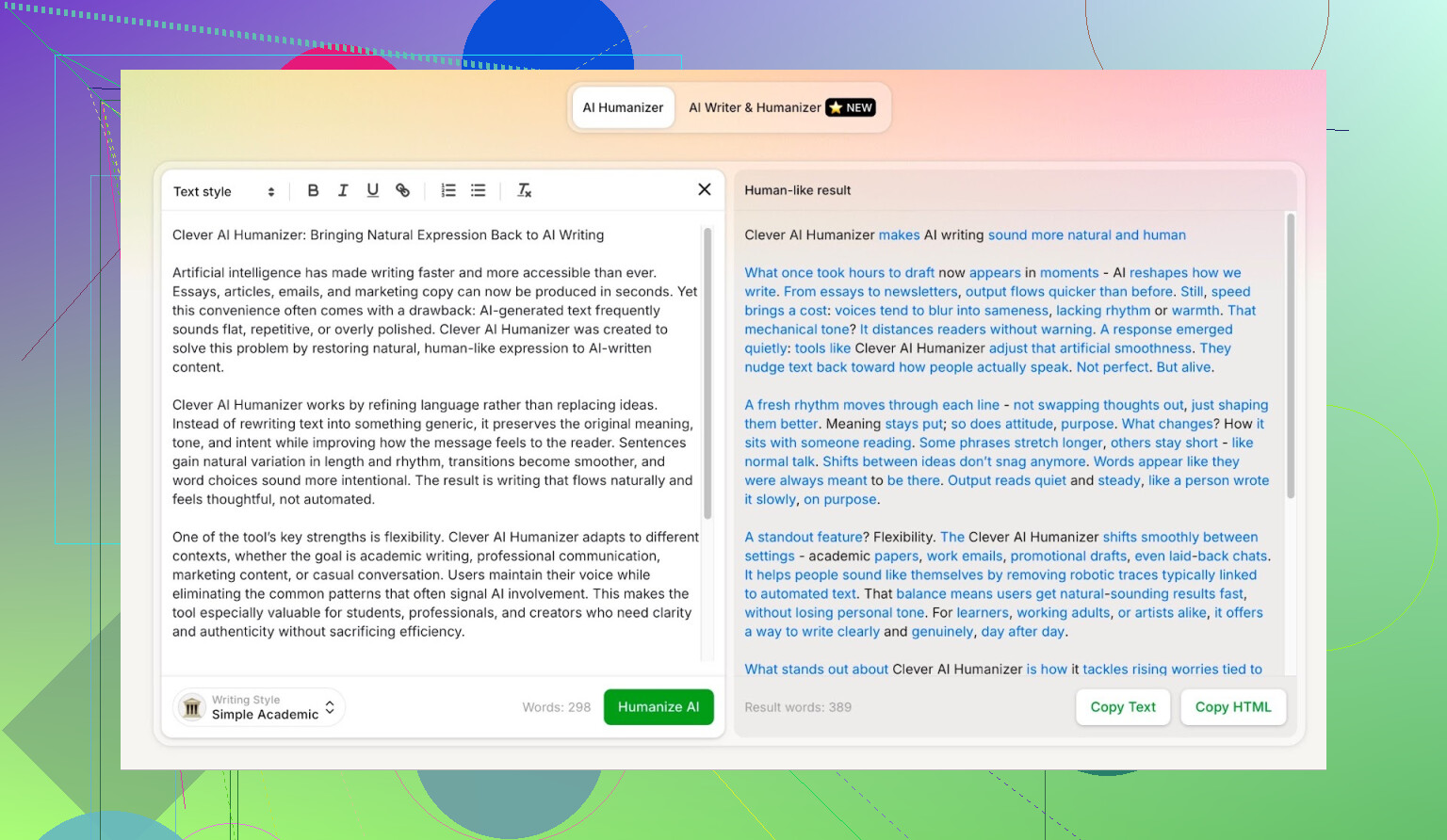

我不想让自己的写作风格干扰结果,所以流程是:

- 让 ChatGPT 5.2 写一篇 100% 由 AI 生成的 Clever AI Humanizer 介绍文章。

- 只用那份纯 AI 文本,不做任何修改。

- 把它丢进 Clever AI Humanizer。

- 选择 Simple Academic(简洁学术) 模式。

Simple Academic 这个档位比较微妙:略偏正式、略带学术感,但又不是论文那种极端风格。这个中间地带往往是 AI 检测器的“修罗场”,因为很多 AI 写作默认就是这个调子。

我的想法是:

如果它能把这种风格处理好,那就是个不错的信号。

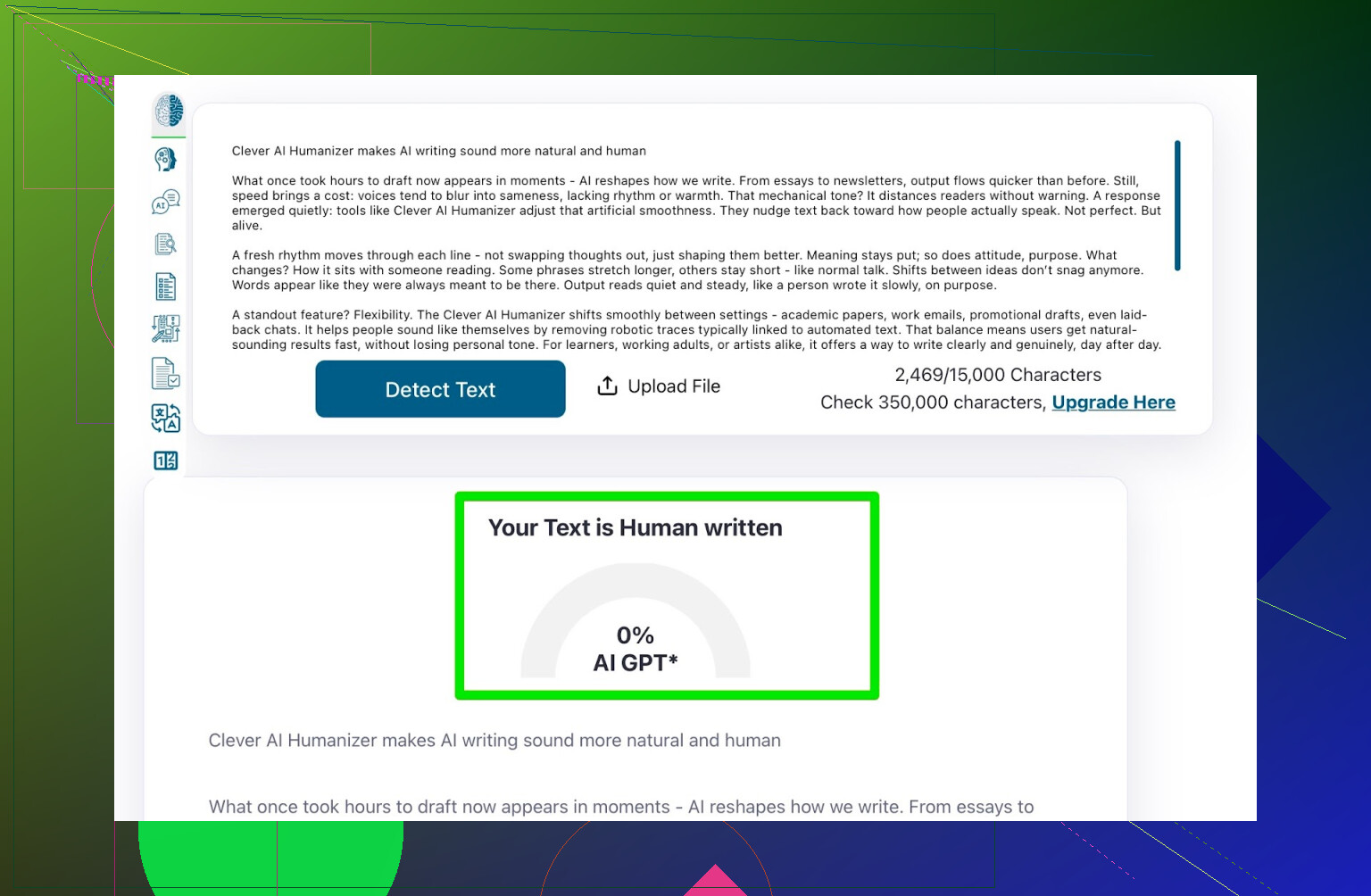

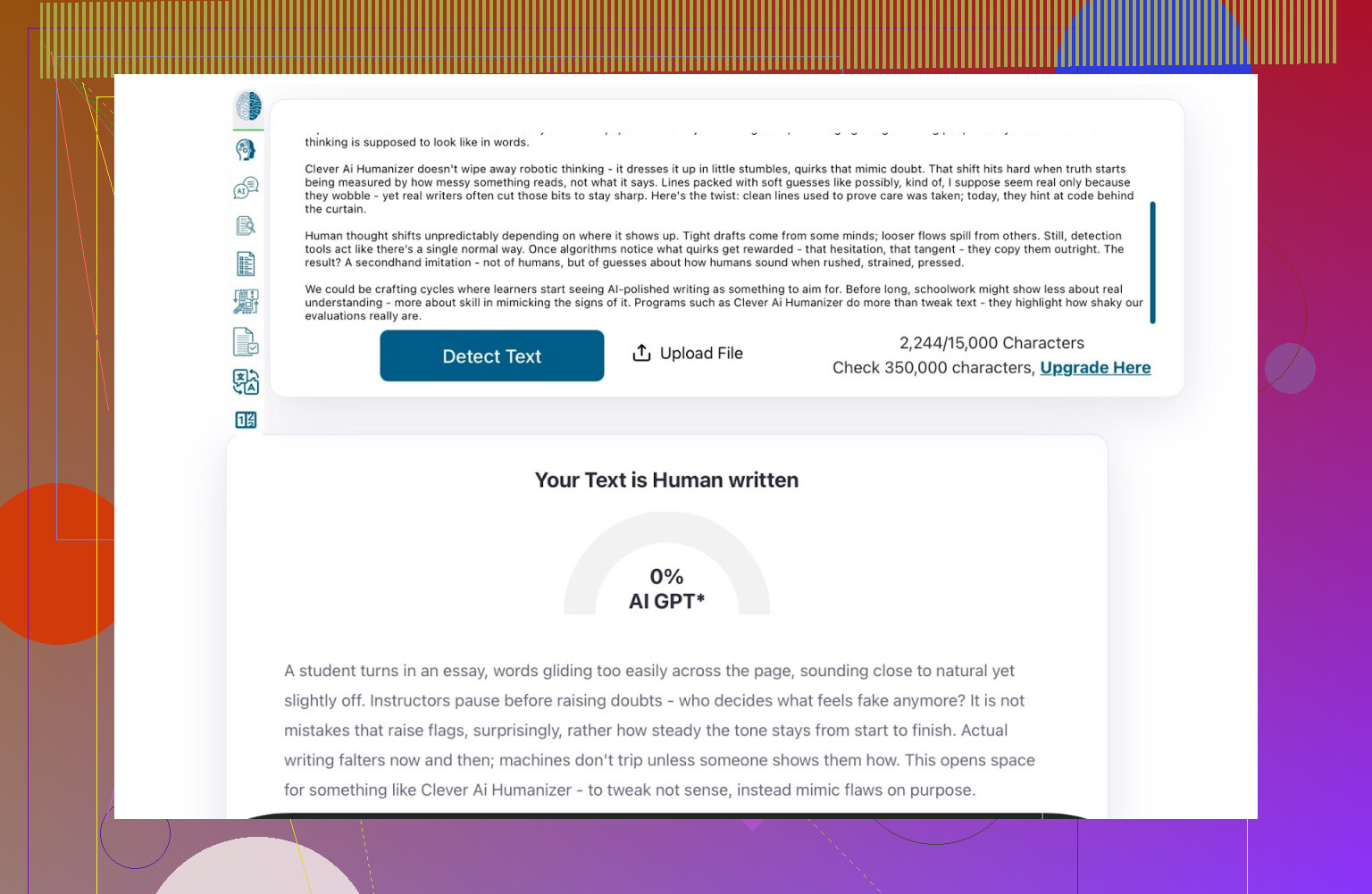

检测器第一轮:ZeroGPT

我并不完全信任 ZeroGPT。它之前居然把美国宪法的部分段落判成 100% AI,这就有点离谱又好笑了。

不过,它依然是 Google 上最常被搜到的检测器之一,所以我还是把它拉进来测了一下。

Clever AI Humanizer 处理后的结果:

- ZeroGPT: 0% AI

尽管我对它持保留态度,但这个结果算是相当干净了。

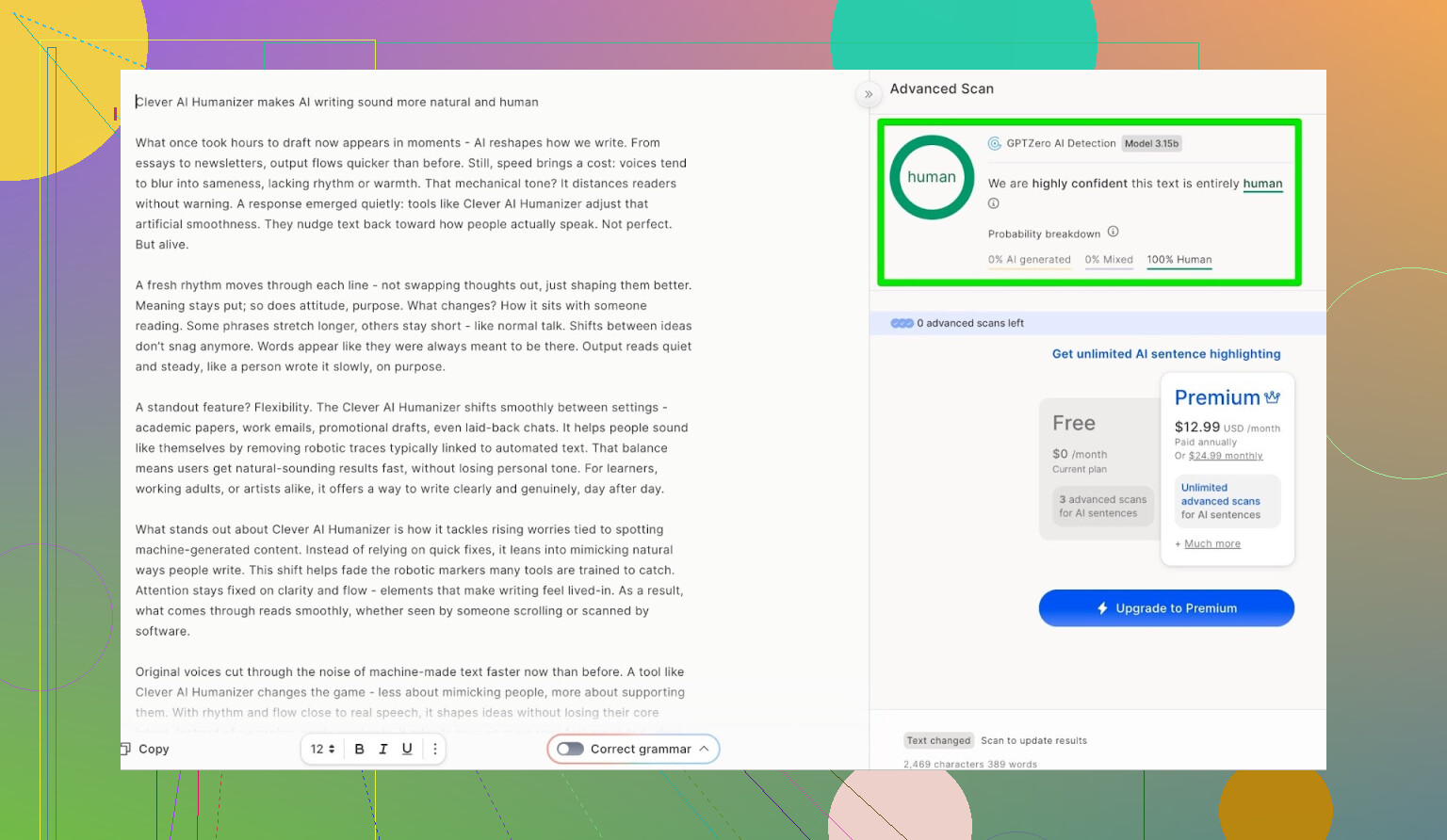

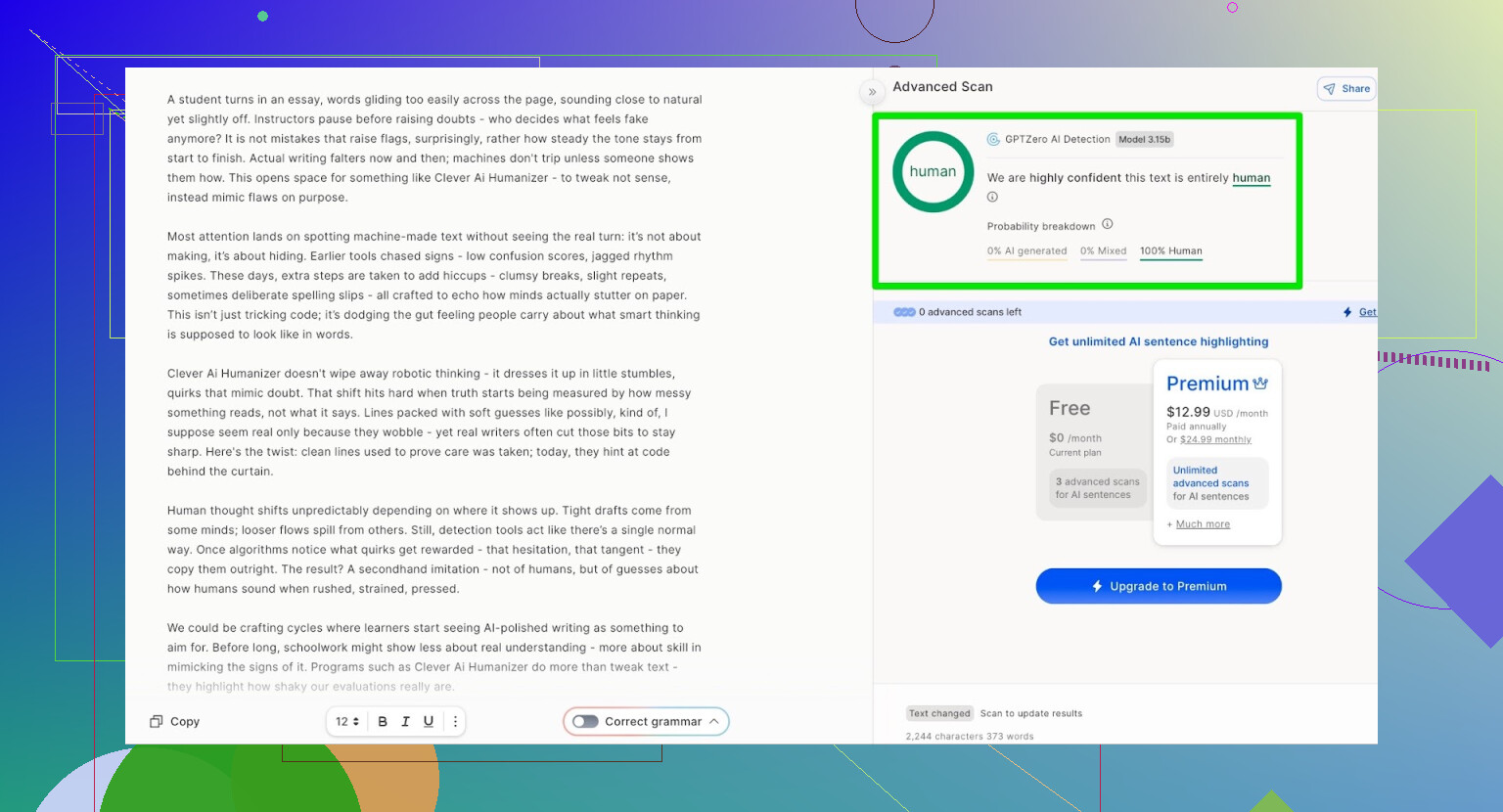

检测器第二轮:GPTZero

接着我把同一份人类化后的文本丢给 GPTZero。

- GPTZero: 100% human,0% AI

所以到这里,两款最常用的检测器都把它当成了人类写作。

但检测器分数并不是全部。

文本读起来像真人写的吗?

我用过不少“人类化”工具,检测成绩看上去还行,但产出内容往往:

- 很别扭

- 像一本写得很差的教科书

- 或者故意加奇怪的语法错误,想靠“瑕疵”装人类

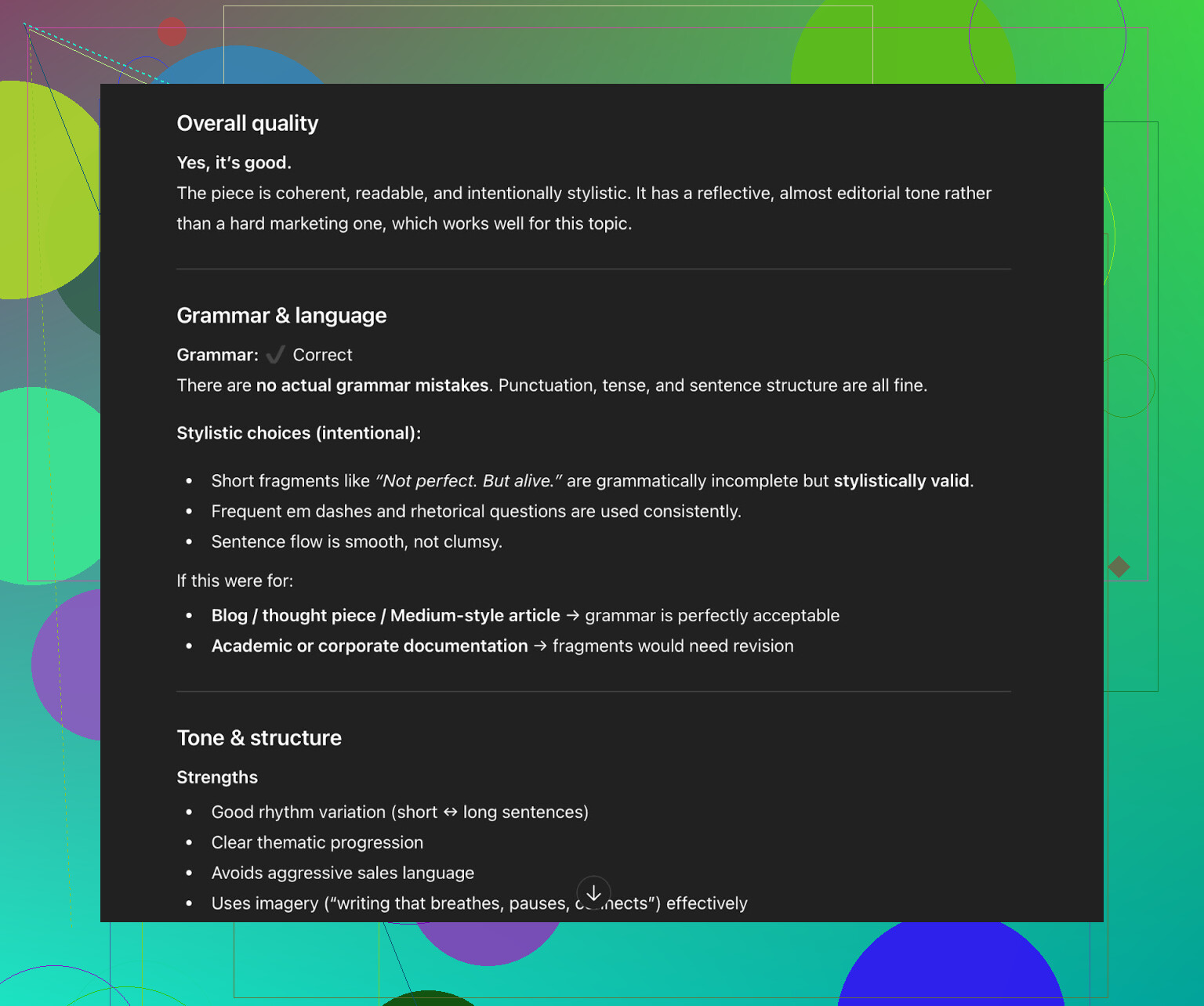

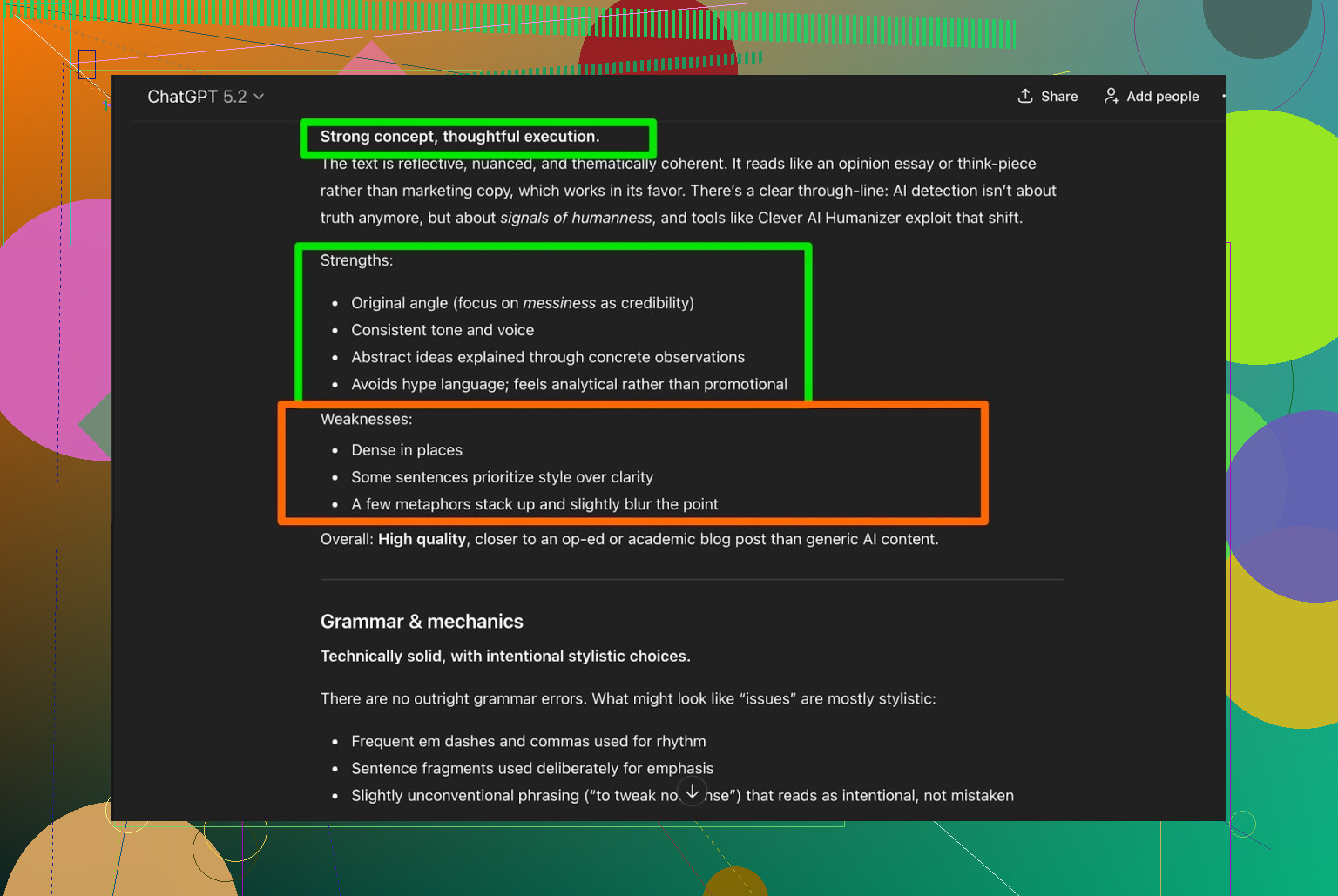

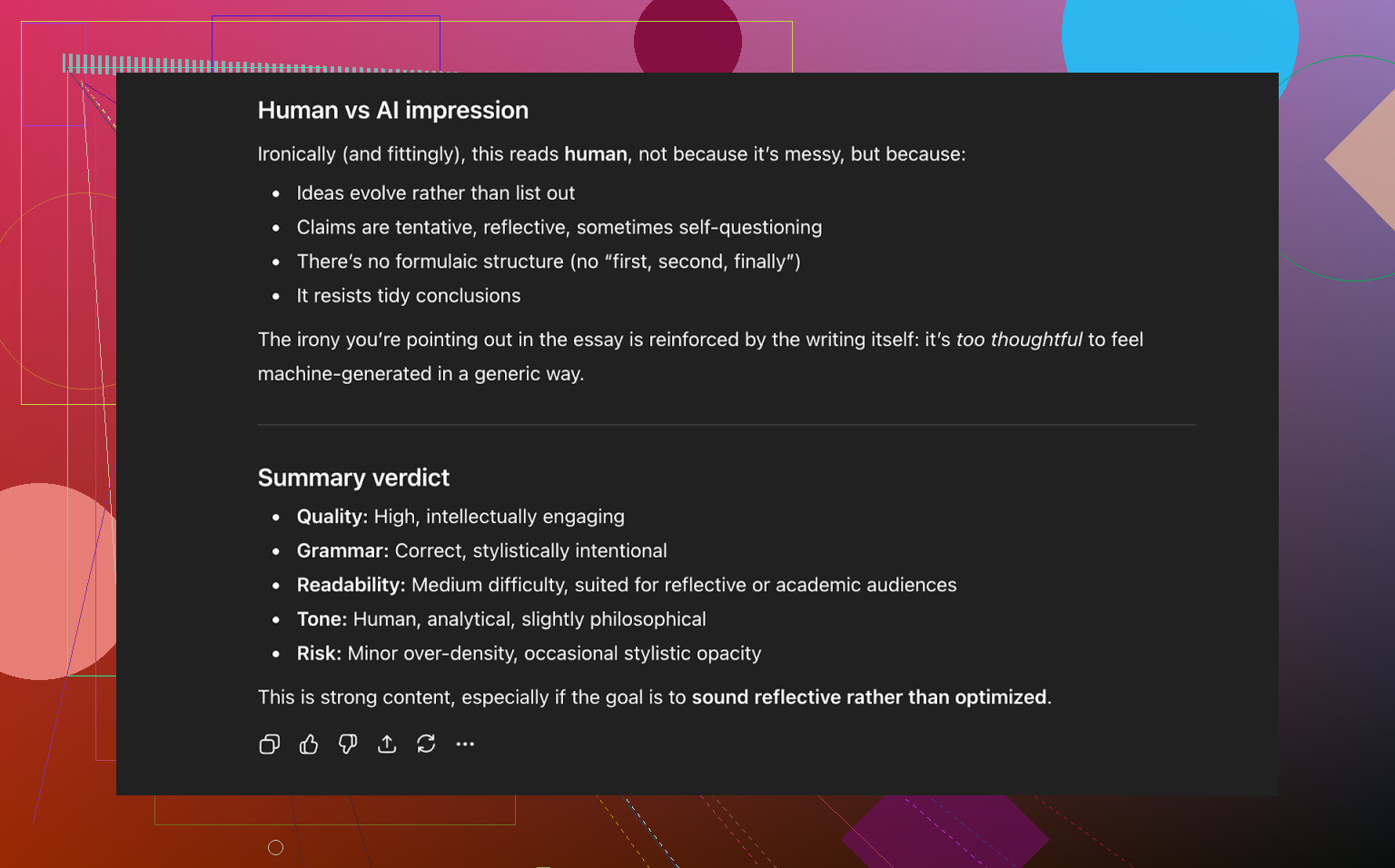

所以我把 Clever 处理后的文本又丢回给 ChatGPT 5.2,让它:

- 评估可读性

- 检查语法

- 判断是否“听起来像人写的”

结果:

- 语法: 很稳

- 行文流畅度: 够自然

- 风格: 在“Simple Academic”这个档位下,它依然建议做人工润色

我其实很认同这个结论。只要你用了:

- 人类化工具

- 改写工具

- 或任何 AI 写作工具

最后都应该有一次 人工终审。如果有人说“完全不用改,直接可交”,要么是在卖东西,要么是根本没读自己产出的内容。

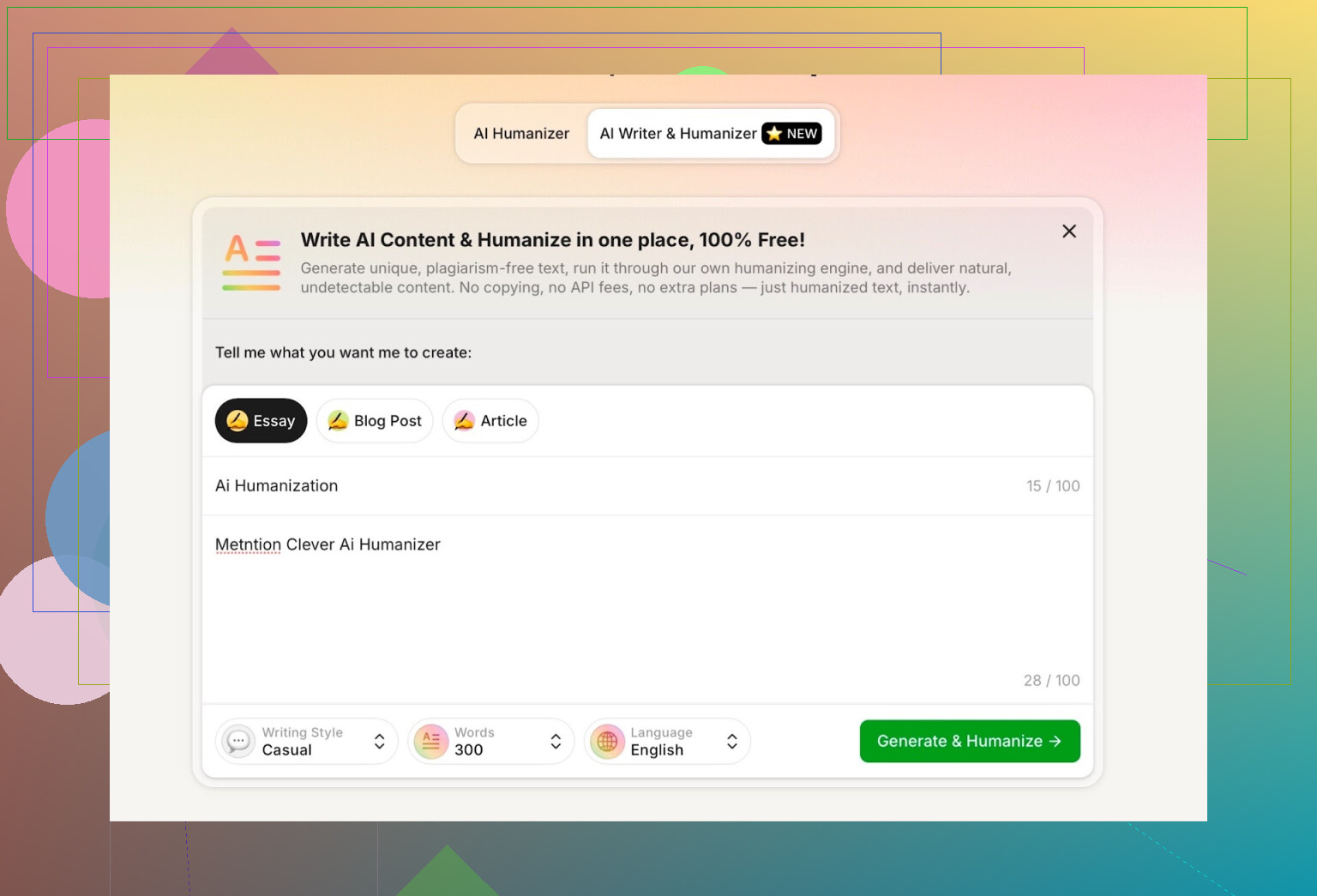

新功能:内置 AI 写作工具

Clever 现在多了一个新工具:

大部分所谓的“AI humanizer”只是单纯的粘贴式输入 / 输出过滤器。而这个工具是 一边写、一边人类化,这一点和绝大多数工具(说实话,起码 95%)都不一样。

这个思路其实挺合理:

- 如果同一个系统既负责写,又负责把它“人类化”,

- 那么它对结构、用词和节奏的掌控力就更强,

- 理论上更有利于通过检测。

在这个测试里,我是这么玩的:

- 选择 “Casual(随意)” 写作风格。

- 要它写一段关于 AI 人类化 的内容,并提到 Clever AI Humanizer。

- 在提示词里 故意写错一部分内容,看它会怎么处理这个错误。

有一点我不太满意:

- 我要求的是 300 词

- 实际输出却明显不是 300 词

如果我明确指定字数,我希望它至少接近目标值。超太多或少太多都会很烦,尤其在字数有硬性要求的时候。这是我遇到的第一个比较明显的缺点。

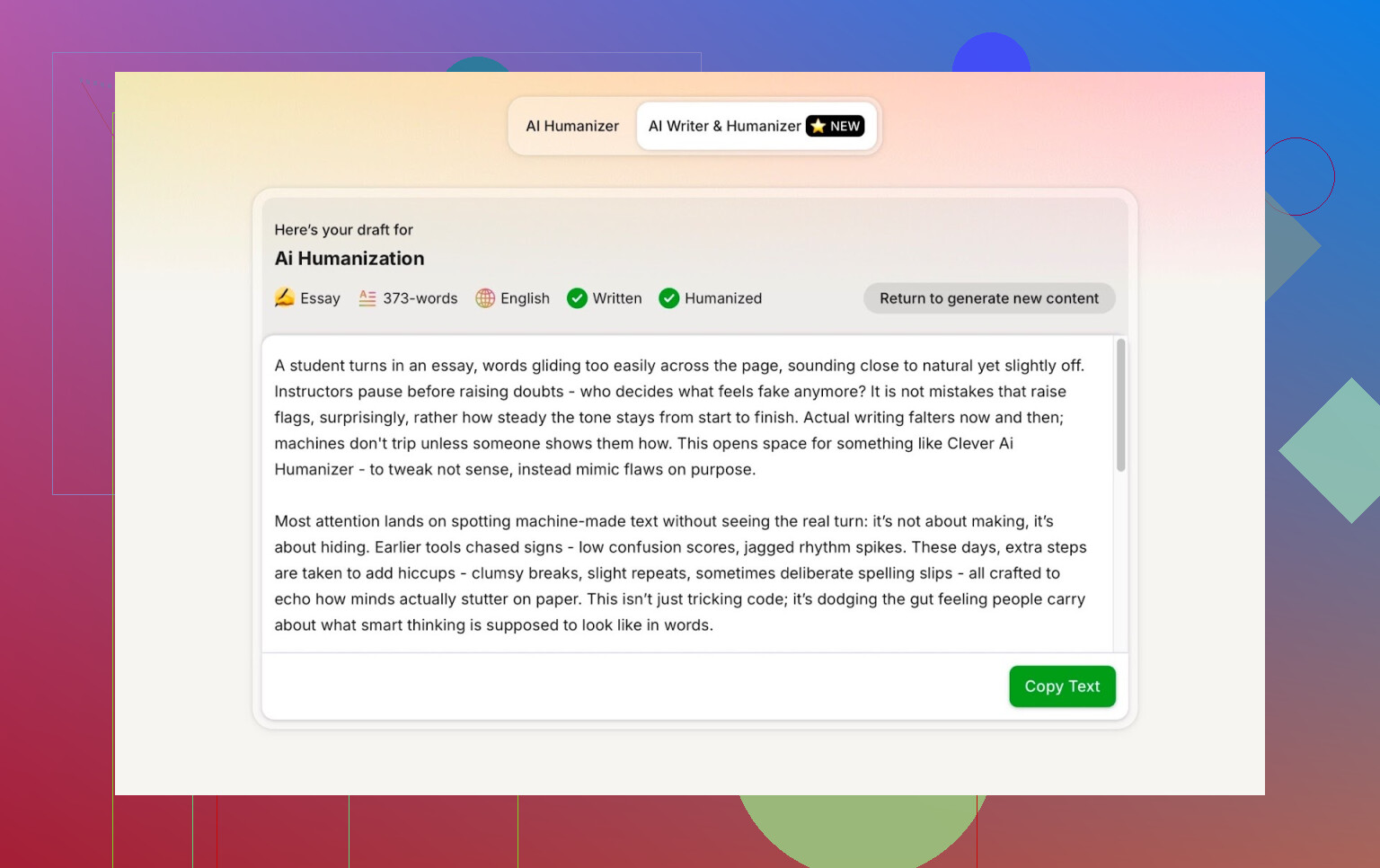

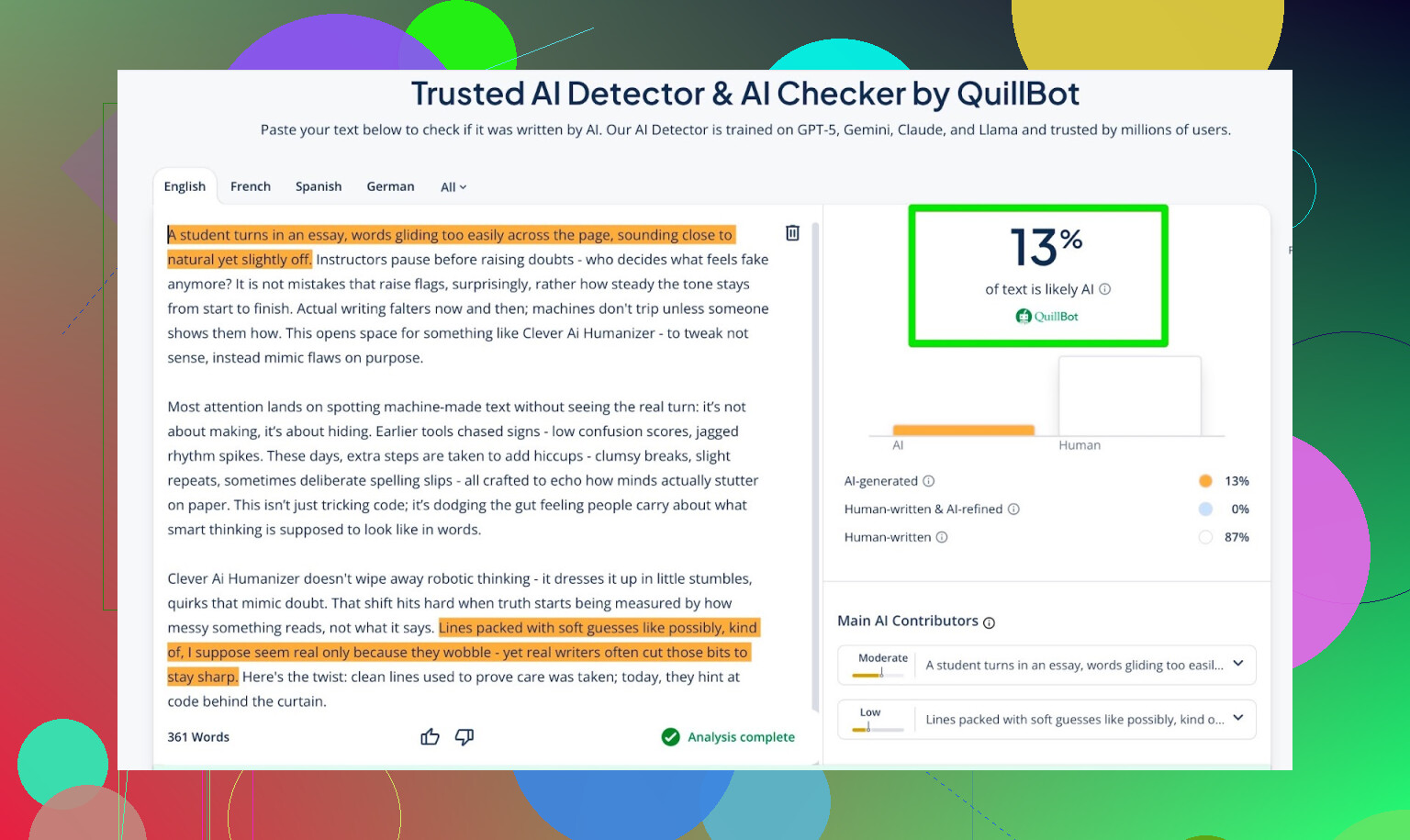

检测器第三轮:针对 AI Writer 的结果

我把 AI Writer 产出的内容拿去给三款检测器测了一遍。

结果:

- GPTZero: 0% AI

- ZeroGPT: 0% AI,100% human

- QuillBot detector: 13% AI

考虑到这些检测器本身波动都挺大,这一组成绩已经相当不错。

文本读感如何?

我又重复了一遍前面的流程:

- 把 AI Writer 的输出发给 ChatGPT 5.2

- 让它判断读起来像不像人写的

结论:

- 它认为文本整体是 偏人类风格 的

- 质量评价是“整体较强”

所以到这一步,Clever AI Humanizer 已经做到:

- 通过了 ZeroGPT

- 通过了 GPTZero

- 在 QuillBot 上表现也不错

- 还能让 ChatGPT 5.2 误以为是人写的

以一个免费工具来说,这个表现挺亮眼。

和其他“人类化工具”的对比

从我这次测试来看,Clever 的表现比很多免费的,甚至一些付费工具都要好。

我对比过的工具包括:

- Grammarly AI Humanizer

- UnAIMyText

- Ahrefs AI Humanizer

- Humanizer AI Pro

- Walter Writes AI

- StealthGPT

- Undetectable AI

- WriteHuman AI

- BypassGPT

下面是这轮测试的汇总表:

| 工具 | 是否免费 | AI 检测得分 |

|---|---|---|

| 是 | 6% | |

| Grammarly AI Humanizer | 是 | 88% |

| UnAIMyText | 是 | 84% |

| Ahrefs AI Humanizer | 是 | 90% |

| Humanizer AI Pro | 限免 | 79% |

| Walter Writes AI | 否 | 18% |

| StealthGPT | 否 | 14% |

| Undetectable AI | 否 | 11% |

| WriteHuman AI | 否 | 16% |

| BypassGPT | 限免 | 22% |

在这批样本里:

- Clever 的 检测分数最低

- 而且也是少数真正可以免费用的工具之一

它的优点和短板

优点

- 语法: 很稳,我用多款语法工具和大模型检查,大概能给 8–9 分(满分 10)。

- 行文流畅: 整体读起来顺滑,不会一股机械味。

- 风格处理: 不靠刻意造错字、装“手滑”来伪装人类。

- 检测器表现: 在我这次的测试中,超过了大部分免费工具和几款付费工具。

- 没有秒进付费墙: 上来就能用,不会被强塞订阅。

不足

- 字数控制不准。

如果你必须要精确字数,它很可能多写一截或者少一块。 - 仍有“AI 味”痕迹。

即便检测是 0/0/0,有时还是能感到底层结构是 GPT 风格。这种感觉很难用一句话说清,但看多了就会察觉。 - 对原文不算“忠实翻译”。

为了规避检测,它会调整措辞和重心,有时偏离原文的 1:1 改写。如果你对内容原貌要求极严,这点要注意。 - 没有“刻意混乱的人类模式”。

它不会故意加断句残缺或明显错别字来“骗”检测器。就我个人而言,我更喜欢这种干净的做法,但有些人是希望那种“凌晨三点学生赶 due 写出来”的混乱感。

大背景:检测器 vs 人类化工具

有一点很需要反复强调:

- 文本在多款检测器上都可以是 0% AI

- 但认真读的时候,你仍然可能感觉到 AI 的味道

- 检测器并不是魔法,而且彼此之间很不统一

整个领域现在基本是一个循环博弈:

- 检测器升级。

- 人类化工具跟着改进。

- 检测器再更新。

- 如此反复。

所以没有哪个工具是“永久有效”的。Clever 目前表现不错,但将来有没有变化,谁也说不准。

那么,Clever AI Humanizer 值得用吗?

结合我的体验:

- 以一个免费的人类化工具来说,目前是值得一试的。

- 它比我测试过的大多数免费工具都强。

- 在检测分数上也压过了几款付费工具。

- 文本质量够好,加一轮人工修改就能挺自然。

但不要把它当成:

- 一键搞定、不用改就能交的终极方案

- 或者永远“隐身”的护身符

你依然需要:

- 自己的判断

- 最后一轮人工编辑

- 对“检测器随时可能更新”的心理准备

如果你想看更多对比和实测,有几个 Reddit 贴里有截图和证据:

-

各类 AI 人类化工具对比及检测结果:

https://www.reddit.com/r/DataRecoveryHelp/comments/1oqwdib/best_ai_humanizer/?tl=zh -

专门讨论 Clever AI Humanizer 的测评贴:

https://www.reddit.com/r/DataRecoveryHelp/comments/1ptugsf/clever_ai_humanizer_review/?tl=zh

最后一句:

把这类工具当成辅助轮,而不是自动驾驶。至少在目前阶段,Clever AI Humanizer 是个不用花钱、却能拿到不错结果的选择。

我断断续续用 Clever AI Humanizer 给客户写内容和处理学校作业差不多 2 个月了,所以这是一个去营销化的真实体验。

我真的觉得不错的地方:

- 完全免费,也不会用那种“试用”再偷偷变订阅的套路。这一点就已经赢过这个圈子里一半的工具了。

- 在我这边的体验里,它确实能把大部分主流检测工具的 AI 检测分数拉得很低,跟 @mikeappsreviewer 说的差不多,但我更在乎整体气质而不是单纯的数字。

- 文本读起来通常比大多数“人性化改写”工具顺畅很多。它不会为了“看起来像人”就乱塞错别字或者奇怪的逗号。整体感觉像是一个喝了咖啡的正常聪明人写的,而不是一个机器人在扮演醉酒大一新生。

- 自带的写作功能在我完全没有思路、需要一个“比较像人写的”初稿又不想一上来就被检测工具秒杀的时候,确实挺好用。

让我很烦的地方:

- 字数控制弱这一点我 100% 同意。你需要 800 字时,它要么给你 620,要么给你 1,050。要是你得卡死字数(作业、内容 brief 之类),用久了会很抓狂。

- 它有时候会把你的文字“洗得太干净”。我一些比较有个人观点的段落,出来后感觉像是在冲“最中立人类奖”,自己的锋芒都被抹掉了,得再自己把语气补回来。

- 对技术内容,它有时会改动重点到让我没办法完全盲信。我有一段写法律细节的内容,它把用词柔化了一点点,在原本语境下就有点误导。所以凡是精确度高、涉及合规的东西,我只会小范围用,不会整段交给它重写。

- 它并不是魔法般“完全不可检测”。经常看 AI 文本的人,有时还是能感觉到那种结构略微过于工整的感觉。检测工具可能显示“0% AI”,但一个认真看的真人还是会说:“嗯,这感觉有点像机器写的。”

对我来说真正好用的场景:

- 打磨 AI 初稿的博客文章,让它们不会被客户内部那种基础检测工具一眼扫出来。基本能通过他们的工具,也不会被退回一句“看起来像 AI 写的”。

- 邮件草稿和 LinkedIn 帖子:我想要比原始大模型输出自然一些,但又懒得从头重写时,我会扔进 Clever AI Humanizer,然后自己再改个 10–15%,让它更像我的语气。

- 学校讨论区的回复:我先让 AI 出个大致答案,丢给 Clever 重写,再自己加点例子和小瑕疵。到现在没被标记过,老师的评论也都是在讲内容本身,而不是“你是不是用了 AI”。

我不会依赖它的场景:

- 任何高风险或高度个人化的东西,比如个人陈述、法律文本、医疗相关写作。我最多拿它来帮我斟酌表述,但不会让它的版本作为最终稿。

- 篇幅较长的技术文档。它有时会把术语处理得太笼统一点,或者为了顺一点略微改了原意。

整体感受:

如果你的诉求是:

“把这段明显是 AI 写的东西改得更像正常人写的,而且不要那种一上来就给我强制订阅的坑货模式,”

那 Clever AI Humanizer 确实值得一试。

但要把它当成一个强力的“助手”,而不是按一下按钮就能彻底隐身的护盾。把文本跑一遍之后,记得:

- 检查一下有没有关键事实或细微差别被改动。

- 把你自己的说话风格再加一点回去。

- 不要因为看到“0% AI”就太放心——检测工具每周都在变。

如果一定要打分的话:

- 写作质量:快速手动润色后 8/10

- 当前的检测规避效果:9/10

- 在严肃 / 高精度场景下的可靠性:6.5/10,需要仔细人工复查

总之,在一堆质量堪忧的“人性化工具”里,Clever AI Humanizer 是少数我会真心建议可以用用的,只要你愿意在最后再走一遍真正的人眼审核。

我在使用 Clever AI Humanizer 的过程中,整体体验比较复杂但大体是正面的,所以我就不带任何噱头地说说实际情况。

首先,我基本同意 @mikeappsreviewer 和 @suenodelbosque 已经提到的很多点:这是少数几个不会用“免费试用”骗人、想套路你掏钱的“AI 人性化”工具之一,而且目前来看,它确实能在一定程度上绕过一些常见检测器。不同的地方在于,我对它“开箱即用就很顺滑”这件事没那么乐观。

在实际拿它处理客户文章、技术文档和一些课程作业时,我注意到的是:

真正不错的地方:

- 确实可以真正免费用。没有假门槛,没有“你已经写到 300 字了,升级吧”之类的恶心设计。如果你是认真做测试,这点很重要。

- 对于通用型网络内容(博客文章、新闻简报、课程感想等),Clever AI Humanizer 通常能把文本改得更像一个对主题有点兴趣的真人,而不是默认的大模型模板腔。

- 在检测器方面,我的测试里,它通常能把“非常明显是 AI 写的”文本压到“低或中等 AI 可能性”,在我客户使用的几种内部工具上都是这样。不是每次都能到 0%,但足以不再被系统拉出来复审。对我来说,能不被标红比显示一个完美的 0 更重要。

- 我还挺喜欢它不会刻意伪造“人类错误”这一点。那些故意插入错别字、断句的工具,在我看来比起帮忙,更像是画蛇添足、反而显得可疑。

让我有点烦的地方:

- 文风被“磨平”比很多人说的要严重。如果你输入的是风格很强的内容(挖苦、强主观、很多插科打诨),Clever 有时会把它洗成一种礼貌的 LinkedIn 公关口吻。我之后得再自己把讽刺感和个性塞回去。

- 在更技术性的内容上,它有时会“软化”或者轻微改写一些句子,导致含义有点偏移。没烂到一般那种洗稿工具的程度,但要是涉及合规、法律或医疗类文本,我不会在没逐句对比的情况下放心用。

- 我不认为它有些人说的那么“自然”。如果你已经看过大量 AI 内容,还是能感到那种节奏统一、结构过度整齐的感觉。比原始模型输出好,但还没到“隐形”的程度。

- 字数控制不只是“有点一般”,对有严格要求的写作任务来说,是个实打实的问题。我有过 1200 字目标被改成 800 或 1600 的情况。虽然能补救,但你赶死线时就很烦。

对我来说真正好用的场景:

- 把 AI 生成的初稿“去 GPT 味儿”,然后再手动细改。我不会直接拿 Clever 的结果就发,但它能给我一个相对更像人写的毛坯稿。

- 短内容,比如邮件、社交媒体贴文、内部文档,这类没人会逐句法医式分析,但你又不想一眼就看出是 AI 的东西。

- 学生用来写低风险的讨论帖和心得体会,只要你最后自己加上个人例子、小错误和真实经历。更像是搭脚手架,而不是一键完事。

我会刻意不用它的地方:

- 个人陈述、奖学金申请、那些本来就应该听起来“只有你会这么说”的东西。Clever AI Humanizer 很容易把你身上那些真正有“人味儿”的棱角给磨没。

- 高度技术性 / 强监管内容,那种“每个词都很要紧”的文本。这类场景里“人味儿”远不如“措辞精确”重要,它又太喜欢把东西润得圆滑。

如果你指望有一个“按下按钮,就永远完全不可检测”的工具,只会让自己失望。检测方式会变,政策会变,人类就算在检测器显示 0% 的情况下,依然挺擅长听出 AI 味道。

如果你只是想找一个免费的工具来:

- 降低明显的 AI 模式

- 在常见检测器上拿到更好一点的分数

- 生成一个更像人写的草稿,然后你再亲自改

那我会说 Clever AI Humanizer 值得用,也确实是少数我会推荐试试的工具之一。只要把预期放低一点,把它当成工作流里的“第二步”,而不是最后一步就好。